Ентропія. Властивості ентропії - Кількісні інформаційні характеристики дискретних джерел повідомлень і каналів

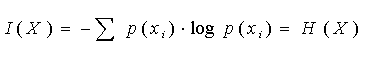

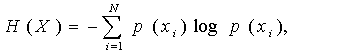

Ентропія визначає міру невизначеності всієї безлічі повідомлень на вході каналу і обчислюється як середня кількість власної інформації у всіх повідомленнях:

(5)

Властивості ентропії:

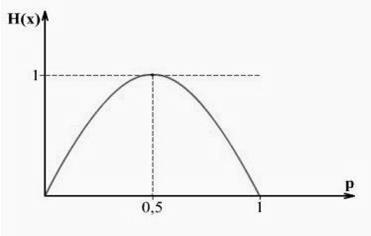

- 1. Ентропія H(X) ненегативна: H(X) > 0. 2. Ентропія H(X) < logn. 3. величина logn = d називається інформаційною пропускною спроможністю алфавіту (інформаційною місткістю алфавіту). 4. якщо n = 2, то p(x1) = p, p(x2) = 1p,

H(Х)= - p log p - (1p) log (1p).

5. Найвища невизначеність, а відтак і максимум ентропії досягається при p = 0,5 і тоді

H(Х) = - log 0,5 = log 2 = 1,

Тобто місткість двійкового алфавіту дорівнює 1 біт.

Залежність H(X) від величини р показано на рис. 7.

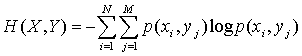

6. Ентропія для об'єднаних ансамблів:

. (6)

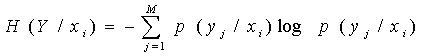

7. Часткова умовна ентропія

. (7)

Рис. 1. Залежність H(X) від величини р

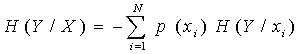

Середнє значення часткових умовних ентропій називається умовною ентропією

. (8)

Вона характеризує невизначеність результату подій у при відомих подіях х.

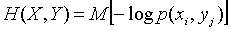

Якщо врахувати, що математичне очікування є результат усереднювання по всіх станах, то вирази (5), (6) і (8) можна записати у вигляді

,

,

Де М - математичне очікування. З теорії ймовірності відомо, що

P(x, у) = p(x) p(у/x) = p(y) p(x/y).

Після логарифмування і застосування операції пошуку математичного очікування одержуємо співвідношення:

H(X, Y) = H(X) + H(Y/X),

H(X, Y) = H(Y) + H (X/Y). (9)

У іншій формі (9) має вигляд

H(X) H (X/Y) = H(Y) H (Y/X). (10)

Ліву частину (10) можна інтерпретувати як середню кількість інформації I(X, Y), доставлену в пункт прийому, яка дорівнює середній кількості переданої інформації H(X) мінус середню кількість інформації H (X/Y), втрачену унаслідок дії шумів:

I(X, Y) = H(X) H (X/Y).

Права частина (10) містить ентропію шуму H(Y/X) при відомому сигналі X:

H(Y/X) = H(Y) H (Y/X).

Обидві частини рівності (10) однаково придатні для визначення середньої кількості переданою по каналу інформації.

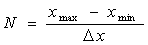

Ентропія систем з безперервною безліччю станів обчислюється за правилами аналізу дискретних систем з попереднім квантуванням щільності ймовірності w (x) з кроком Дх.

Тоді число станів в системі буде дорівнювати

,

А ймовірність станів p(xI)= w (xI) Дх.

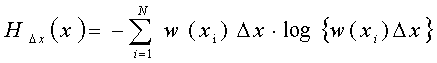

Використовуючи відомі формули даного розділу, можемо одержати ентропію

.

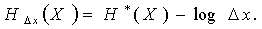

Після перетворень і устремління Дх ?до нуля одержуємо

(11)

Величина H*(X) називається приведеною ентропією. Вона дорівнює:

(12)

Похожие статьи

-

При введенні кількісної міри інформації (Норберт Вінер і Клод Шеннон) було прийнято смисловий зміст повідомлень (семантику) не враховувати, а обмежитися...

-

Припустимо, що ми маємо дискретний канал, імовірність виникнення помилки в якому є близькою до нуля (у ідеалі = 0). Такий канал називають ідеальним...

-

Звичайно джерела передають повідомлення з деякою швидкістю, витрачаючи в середньому час Т на передачу одного повідомлення. Продуктивністю джерела...

-

Функції інформації - Кількісні інформаційні характеристики дискретних джерел повідомлень і каналів

Як уже підкреслювалося, інформацією називають відомості про навколишній світ, про процеси, що протікають в ньому. Інформація, зафіксована на носіях,...

-

Джерела інформації мають фізичну природу, відрізняються по виду формованих повідомлень, енергетичній активності, імовірнісним характеристикам. Для...

-

Більшість пристроїв інформаційних систем відносяться до класу лінійних систем, які представляються у вигляді чотириполюсника з передатною функцією K(iщ)....

-

У техніці інформацією вважається будь-яка послідовність символів, що зберігається, оброблювана або передана. Часто використовують простий і грубий спосіб...

-

Оскільки інформатика має справу з процесами передачі і зберігання інформації, те важливе значення має кількісне вимірювання інформації. При цьому різні...

-

Імовірнісний характер інформації (де, коли, які повідомлення, скільки їх), імовірнісний характер перешкод потребують переходу від детермінованої моделі...

-

Математичні моделі завад - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку

Природа завад різноманітна: шуми космічних об'єктів, атмосферні процеси, завади від сусідніх станцій, індустріальні завади й т. д. Сигнал, що надійшов на...

-

Математичні моделі сигналів - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку

Відеосигнали u(t), розглянуті в 1, не є основними переносниками інформації. Вони переносять її по внутрішніх ланцюгах. Переносниками інформації на далекі...

-

При организации самостоятельной сети АТ нагрузку каналов в ЧНН между проектируемой и i-й станциями можно представить в следующем виде, Эрл , (23) Общий...

-

Сьогодні практично всі сучасні телекомунікаційні технології передбачають використання цифрових методів обробки й передачі інформації, побудову...

-

Загальні відомості про телевізійні антени - Технічні характеристики телевізійних антен

Приймальні телевізійні антени перетворять енергію електромагнітних хвиль у ВЧ-енергію, що поступає по фідеру (звичайно це коаксіальний кабель) до...

-

Формирование сбытовой политики основано на использовании элемента комплекса маркетинга "доведение продукта до потребителя", характеризующего деятельность...

-

Беспроводные оптические каналы - Обеспечение абонентской связи путем радиодоступа поселка Федоровка

2.8.1 Беспроводные оптические каналы связи (БОКС) предназначены для создания каналов передачи данных типа точка-точка между объектами, находящимися на...

-

Для определения необходимого числа каналов на участках между проектируемой станцией и заданными узлами связи дороги воспользуемся номограммой. Процент...

-

При расчетах каналов и оборудования телеграфных станций сети ПС необходимо учитывать не только нагрузку по передаче и приему телеграмм, но и нагрузку в...

-

ЗАГАЛЬНІ ХАРАКТЕРИСТИКИ - Аналогові вимірювальні прилади. Принципи дії, властивості й застосування

Аналогові вимірювальні прилади, як правило, забезпечують виконання прямих вимірювань, відлік результату вимірювань виробляється по шкалі. Режим...

-

Аналітичні методи побудови перехідних характеристик грунтуються на розв'язку диференціального рівняння системи. Для цього може бути використаний як...

-

Определяем общее число пролетов на магистрали: ; (5.1[3]), Где Lмаг - общая длина ЦРРЛ; Lпрол - длина пролета. Подставляя числовые значения в (5.1[3]),...

-

Цепи поставок - Планирование цепи поставок и канала распределения производственного предприятия

Логистическая цепь (ЛЦ) -- это множество звеньев логистической системы, упорядоченных (оптимизированных) по материальному (информационному, финансовому)...

-

Прокладка ОК в кабельной канализации может выполняться вручную или механизированным способом с использованием комплекта приспособлений для прокладки...

-

Регулировочная характеристика СИФУ при косинусоидальном опорном напряжении определяется выражением . (7.1) При линейной пилообразной форме опорного...

-

Принцип спектрального уплотнения (WDM) Потенциальные ресурсы волокна. До настоящего времени на многих коммерческих линиях использовалась скорость...

-

Розробка функціональної схеми моноімпульсної РЛС Виходячи з послідовності операцій, які виконує моноімпульсни система, її функціональна схема повинна...

-

Данная методика расчета основана на методе динамики моментов, базирующегося на тех же исходных линейных дифференциальных уравнениях теории непрерывных...

-

Двійкові завадостійкі коди, Характеристики корегуючих кодів - Цілісність і доступність інформації

Характеристики корегуючих кодів Завадостійке (надмірне) кодування, що припускає розробку і використовування корегуючих (завадостійких) кодів, широко...

-

Общие характеристики стандарта GSM В соответствии с рекомендацией СЕРТ 1980 г., касающейся использования спектра частот подвижной связи в диапазоне...

-

У відповідності до завдання нам потрібно розробити мікропроцесорний прилад для повірки фазометрів. Завдання зводиться до реалізації генератора...

-

Стандарт IEEE 802.11g является логическим развитием стандарта 802.11b/b+ и предполагает передачу данных в том же частотном диапазоне, но с более высокими...

-

Графоаналитический метод анализа Этот метод используется в тех случаях, когда отсутствует отсечка тока. Этот метод известен под названием трех (пяти,...

-

Построение динамической характеристики автомобиля - Расчет эксплуатационных показателей автомобиля

Для построения динамической характеристики рассчитывают динамический фактор по формуле: Значения сил РТ и Рв берут из таблицы 2.1. Результаты расчета...

-

Наиболее распространенным является создание резервных связей между коммутаторами на основе двух технологий: 1. Режим резервирования, когда одно из...

-

Вступ, Основні поняття - Проектори: основні характеристики

Перший проектор з'явився в 1640 р. Його винайшов німецький фізик і математик, чернець Панас Кирхер (1601-1680). У латинському трактаті "Велике мистецтво...

-

МікроЕОМ серії К1814 являють собою чотирирозрядні ОМЕОМ, призначені для побудови різних систем керування. До складу серії входить універсальна мікро-еом...

-

Эксплуатационные ограничения ОСН сохраняет работоспособность в условиях открытой атмосферы влажностью от 0 до 100% и при температуре от -40 до +40...

-

Загальна характеристика синхронної цифрової ієрархії (SDH) - Синхронна цифрова ієрархія

Основною відмінністю технології SDH від PDH є використання іншого принципу мультиплексування. Технологія SDH основана на повній синхронізації всіх...

-

Основні властивості об'єктів регулювання - Системи автоматичного управління

Об'єкт керування (регулювання) -- це окрема машина, апарат, пристрій, технологічний процес або сукупність технічних засобів (машин, апаратів, пристроїв),...

-

Види і характеристики радіо - і телевізійних антен

Види і характеристики радіо - і телевізійних антен Приймальні телевізійні антени перетворять енергію електромагнітних хвиль у ВЧ-енергію, що поступає по...

Ентропія. Властивості ентропії - Кількісні інформаційні характеристики дискретних джерел повідомлень і каналів