Вимірювання інформації в техніці - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку

У техніці інформацією вважається будь-яка послідовність символів, що зберігається, оброблювана або передана. Часто використовують простий і грубий спосіб визначення кількості інформації, який може бути названий об'ємним. Він заснований на підрахунку кількості символів в повідомленні, тобто пов'язаний з його довжиною і не враховує змісту.

Довжина повідомлення залежить від числа різних символів, що вживаються для запису повідомлення. У обчислювальній техніці застосовуються дві стандартні одиниці вимірювання: біт (двійковий знак двійкового алфавіту {0,1}) мінімальна одиниця вимірювання інформації і байт (який дорівнює восьми бітам, є одним символом, тобто при введенні з клавіатури цього символу машині передається 1 байт інформації). Використовувані в обчислювальній техніці інші одиниці вимірювання інформації уже наведені вище.

Інформаційний об'єм повідомлення (інформаційна місткість повідомлення) кількість інформації в повідомленні, зміряне в бітах, байтах або похідних величинах.

Вимірювання інформації в теорії інформації (інформація, як знята невизначеність).

Палкий закоханий, знаходячись в розлуці, з об'єктом своєї любові, посилає телеграму; "Любиш?". У відповідь приходить не менш лаконічна телеграма: "Так!". Скільки інформації несе у відповідь телеграма? Альтернатив тут дві або "Так", або "Ні". Їх можна позначити знаками двійкового коду 1 і 0. Таким чином, у відповідь телеграму можна було б закодувати всього одним двійковим символом.

Чи можна сказати, що у відповідь телеграма несе одну одиницю інформації? Отримання інформації (її збільшення) одночасно означає збільшення знання або зменшення інформаційної невизначеності.

Книга лежить на одній з двох полиць - верхньої або нижньої. Повідомлення про те, що книга лежить на верхній полиці зменшує невизначеність в два рази.

У простому випадку вибір одного з двох повідомлень ("так" чи "ні", 0 або 1) приймають за одиницю інформації. Вона названа "біт" або двійкова цифра. Питання цінності цієї інформації для одержувача це вже з іншої області і буде розглянуте нижче.

Повідомлення про те, як впала монета "гербом" або "решкою" несе один біт інформації.

Відомо, що Петренко живе на вулиці Весняній. Повідомлення про те, що номер його будинку парний, зменшило невизначеність удвічі, ми стали знати більше, але інформаційна невизначеність залишилася.

Чому в цьому випадку ми не можемо сказати, що інформаційна невизначеність зменшилася удвічі? Якщо вам важко відповісти на це питання, уявіть собі вулицю, на парному боці якої, наприклад, чотири будинки, а на непарній двадцять. Такі вулиці не така вже велика рідкість.

Дуже приблизно можна сказати, що кількість інформації в повідомленні про якусь подію співпадає з кількістю питань, які необхідно задати, щоб одержати ту ж інформацію, відповідь на ці питання може бути лише "так" чи "ні".

У теорії інформації під кількістю інформації розуміють міру зменшення невизначеності знання. Знаходження такої міри вимагає оцінки і обліку кількості переданої інформації. У теорії інформації кількістю інформації називають числову характеристику сигналу, яка не залежить від його форми і змісту і характеризує невизначеність, яка зникає після отримання повідомлення у вигляді даного сигналу. В цьому випадку кількість інформації залежить від вірогідності отримання повідомлення про ту або іншу подію.

Для абсолютно достовірної події (подія обов'язково відбудеться, тому її імовірність дорівнює 1) кількість інформації в повідомленні про неї дорівнює 0. Чим неймовірніша подія, тим більшу інформацію про нього несе повідомлення. Лише при рівноімовірних відповідях відповідь "та" чи "ні" несе один біт інформації.

Існує безліч ситуацій, коли можливі події мають різну імовірність реалізації. Наприклад, якщо монета несиметрична (одна сторона важча іншій), то при її киданні вірогідності випадання "орла" і "решки" розрізнятимуться.

Ми уже мали нагоду обговорити формулу для обчислення кількості інформації, запропоновану Хартлі про об'єкт, який може знаходитися в одному з рівноімовірних N станів:

I = log2N.

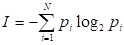

Формулу для обчислення кількості інформації для подій з різною вірогідністю запропонував К. Шеннон в 1948 р. В цьому випадку кількість інформації визначається за формулою:

,

Де I кількість інформації, N кількість можливих подій, pI імовірність окремих подій.

Наприклад, хай при киданні несиметричної чотиригранної піраміди вірогідності окремих подій будуть наступними: 1/2, 1/4, 1/8, 1/8. Тоді кількість інформації, яку ми одержимо після реалізації одного з них, можна розрахувати по формулі Шеннона:

I = (1/2*log1/2 + 1/4*log1/4 + 1/8*log1/8 + 1/8*log1/8) біт = 1,75 біт.

Похожие статьи

-

Оскільки інформатика має справу з процесами передачі і зберігання інформації, те важливе значення має кількісне вимірювання інформації. При цьому різні...

-

Джерела інформації мають фізичну природу, відрізняються по виду формованих повідомлень, енергетичній активності, імовірнісним характеристикам. Для...

-

Імовірнісний характер інформації (де, коли, які повідомлення, скільки їх), імовірнісний характер перешкод потребують переходу від детермінованої моделі...

-

Математичні моделі сигналів - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку

Відеосигнали u(t), розглянуті в 1, не є основними переносниками інформації. Вони переносять її по внутрішніх ланцюгах. Переносниками інформації на далекі...

-

Математичні моделі завад - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку

Природа завад різноманітна: шуми космічних об'єктів, атмосферні процеси, завади від сусідніх станцій, індустріальні завади й т. д. Сигнал, що надійшов на...

-

Більшість пристроїв інформаційних систем відносяться до класу лінійних систем, які представляються у вигляді чотириполюсника з передатною функцією K(iщ)....

-

При введенні кількісної міри інформації (Норберт Вінер і Клод Шеннон) було прийнято смисловий зміст повідомлень (семантику) не враховувати, а обмежитися...

-

Звичайно джерела передають повідомлення з деякою швидкістю, витрачаючи в середньому час Т на передачу одного повідомлення. Продуктивністю джерела...

-

Опис функціональної схеми модему - Захист інформації від витоку з телефонної мережі зв'язку

На рис. 7.2 представлена функціональна схема мікросхеми СМХ869, а в таблиці 7.1 наведено опис вхідних і вихідних сигналів. Рисунок 7.2 Функціональна...

-

Функції інформації - Кількісні інформаційні характеристики дискретних джерел повідомлень і каналів

Як уже підкреслювалося, інформацією називають відомості про навколишній світ, про процеси, що протікають в ньому. Інформація, зафіксована на носіях,...

-

Модель системи зв'язку - Цілісність і доступність інформації

В наслідок впливу завад та шумів результуючий сигнал SРез(t) на виході каналу зв'язку є сумою (для адитивних завад, які, як правило, домінують в каналах...

-

Величина Кв при рівномірному квантуванні визначається Кв= 3L2/.(2.6) З цієї формули ми зможемо знайти число рівнів квантування L Кв. ? Кв. доп. Кв....

-

Припустимо, що ми маємо дискретний канал, імовірність виникнення помилки в якому є близькою до нуля (у ідеалі = 0). Такий канал називають ідеальним...

-

Пристрій може виявляти й декодувати сигнали малої амплітуди. Для досягнення цього DVDD, AVDD і VBIAS повинні бути розв'язані, а тракт прийому ?...

-

Ентропія визначає міру невизначеності всієї безлічі повідомлень на вході каналу і обчислюється як середня кількість власної інформації у всіх...

-

Цей канал, як і радіоканал, становить підвищену небезпеку. Електричний канал утвориться в технічних засобах і комунікаціях через паразитні зв'язки й...

-

Канали витоку інформації - Захист інформації від витоку з телефонної мережі зв'язку

Системи, створені спеціально для передачі інформації використаються людьми в повсякденній практиці у відповідності зі своїм призначенням і є офіційними...

-

Вступ - Захист інформації від витоку з телефонної мережі зв'язку

На сучасному етапі, коли відбулася корінна переоцінка цінностей, багато традиційних ресурсів людського прогресу втрачають своє першорядне значення. Але...

-

Двійкові завадостійкі коди, Характеристики корегуючих кодів - Цілісність і доступність інформації

Характеристики корегуючих кодів Завадостійке (надмірне) кодування, що припускає розробку і використовування корегуючих (завадостійких) кодів, широко...

-

У практиці передачі інформації часто потрібно представити сигнал у вигляді сукупності його послідовних наближень. Наприклад, при перегляді і передачі...

-

Підвищення вірогідності передачі При передачі даних по каналах зв'язку завжди виникають помилки. Причини їх можуть бути всілякі, але результат...

-

Цифрові скремблери - Захист інформації від витоку з телефонної мережі зв'язку

Під скремблюванням розуміється зміна характеристик речового сигналу таким чином, що отриманий модульований сигнал, маючи властивості нерозбірливості й...

-

Особливості обробки сигналів в системі мобільного зв'язку з ЦДУ Як відомо, ємність СМЗ обумовлена кількістю абонентів, які вона може обслужити, є дуже...

-

Вступ, Пристрій введення текстової інформації - Класифікація ввідних пристроїв

Процес взаємодії користувача з персональним комп'ютером (ПК) неодмінно включає процедури введення вхідних даних та отримання результатів обробки ПК цих...

-

Мостовий метод вимірювання частоти - Вимірювання частоти

Цей метод оснований на використанні частотно залежних мостів змінного струму, які живляться напругою вимірюваної частоти. Найбільш поширеною мостовою...

-

Данная методика расчета основана на методе динамики моментов, базирующегося на тех же исходных линейных дифференциальных уравнениях теории непрерывных...

-

Класифікація радіорелейних систем передачі - Засоби радіорелейного зв'язку

Існує безліч різних класифікацій радіорелейних систем передачі (РРСП) у залежності від ознак, покладених у їхню основу. За належністю до різних служб...

-

Основні параметри абонентських пристроїв - Захист інформації від витоку з телефонної мережі зв'язку

Оскільки модем є, по суті, абонентським пристроєм до нього повинні бути пред'явлені вимоги ДЕРЖСТАНДАРТ 7168-86, у якому регламентуються вимоги до АП...

-

Основні мережні сервіси - Оперативні способи зв'язку

Практично всі послуги мережі Internet побудовані на принципі "клієнт-сервер". Сервер (у мережі Internet) - це комп'ютер або програма, здатні надавати...

-

Форми адекватності інформації - Теорія інформації як основа інформаційних технологій

Адекватність інформації може виражатися в трьох формах: семантичної, синтаксичної, прагматичної. Синтаксична адекватність. Вона відображає...

-

Принципи побудови завадостійких кодів - Цілісність і доступність інформації

Найчастіше як передумову при введенні кодів розглядають деякий початковий набір з m двійкових символів "0"и "1" (двійковий вектор), званий часто базовим...

-

Протоколи MNP - Захист інформації від витоку з телефонної мережі зв'язку

Одним з перших протоколів виправлення помилок став протокол MNP (Microcom Networking Protocol), розроблений фірмою Microcom. Він виявився настільки...

-

Стандарт IEEE 802.11g является логическим развитием стандарта 802.11b/b+ и предполагает передачу данных в том же частотном диапазоне, но с более высокими...

-

Способи модуляції - Захист інформації від витоку з телефонної мережі зв'язку

У модемах для телефонних каналів, як правило, використаються три види модуляції: частотна, відносна фазова (фазоразностна) і квадратурна амплітудна...

-

Загальна схема системи зв'язку - Теорія інформації як основа інформаційних технологій

Вона складається з 5 частин: 1. Джерело повідомлень, що створює повідомлення або послідовність повідомлень, які повинні бути передані. Повідомлення...

-

Введемо слідуючі елементарні події: А) - відсутність підключення до лінії, використання її хазяїном і по призначенню, В - наявність підключення або...

-

Канали, що комутуються, надаються споживачам на час з'єднання на їх вимогу (заявці). Такі канали принципово містять у своєму складі комутаційне...

-

Аналогові й цифрові канали Під каналом зв'язку розуміють сукупність середовища поширення й технічних засобів передачі між двома канальними інтерфейсами...

-

Чутливість надпровідної петлі СКВІДів до зміни енергії озволяє використовувати їх у якості датчиків енергії [11]. Передача енергії надпровідному...

-

Вступ, Приймальні супутникові антени. Параболічні антени - Супутникові системи зв'язку

Ознайомитися з сучасними супутниковими системами зв'язку, з технічними можливостями виведення супутника на навколоземну орбіту, а також з його...

Вимірювання інформації в техніці - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку