Кількісна міра інформації - Кількісні інформаційні характеристики дискретних джерел повідомлень і каналів

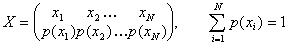

При введенні кількісної міри інформації (Норберт Вінер і Клод Шеннон) було прийнято смисловий зміст повідомлень (семантику) не враховувати, а обмежитися тільки формальними ознаками, важливими з погляду передачі повідомлень по каналах зв'язку. У результаті враховуються тільки число N повідомлень, що підлягають передачі, і ймовірності р(хI) надходження їх на вхід каналу. Всю сукупність повідомлень представляють у вигляді деякої системи Х із станами xI

, (1)

Де: xi - окремі повідомлення (або їх типи, класи), p(xi) - апріорна ймовірність появи повідомлень xi.

В результаті передачі повідомлення xI по каналу зв'язку буде одержане повідомлення yJ. Воно може з деякою ймовірністю бути схоже на будь-яке з (x1, x2,...xN) повідомлень. Зокрема воно може бути схоже на передане повідомлення xi. Апостеріорна (післядослідна) ймовірність присутності xI в yJ дорівнює p(xI/ yJ).

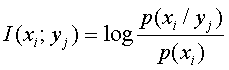

У основу міри кількості інформації встановлені зміни ймовірності появи повідомлень від апріорного значення p (xI) на вході каналу до апостеріорного значення p (xi/yj) на виході каналу, пов'язані із викривленнями інформації у каналі.

Порівнюючи ймовірність р(xI) і p (xI/yJ) можна встановити міру кількості інформації, переданої через даний канал. Зручною мірою виявився логарифм відношення апостеріорної ймовірності до апріорної.

Кількість інформації, те, що міститься в події yJ щодо події xI визначається по формулі

. (2)

Основою логарифма можуть бути: 2, е 2,72, або 10. Залежно від основи міняються одиниці вимірювання кількості інформації (біти дв. од.; ніт нат. од.; хартлі (діти) дес. од.)

Властивості кількості інформації I(xI; yI):

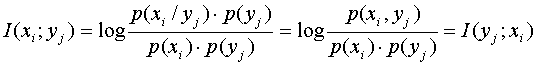

1. Властивість симетрії. Інформація, що міститься в yj щодо xi, дорівнює інформації, що міститься в xi щодо yj. Це стає очевидним, якщо чисельник і знаменник в (1) помножити на p (yi) і виробити перетворення:

,

Оскільки p (xI, yJ) = p (yJ), p(xI/ yJ) = p (xI), p (yJ/ xI) - ймовірність сумісної появи yJ і xI.

В результаті вказаної властивості величину I(xI;yJ) називають кількістю взаємної інформації між xI і yJ.

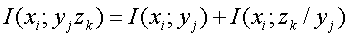

2. Властивість адитивності. Інформація, що міститься в парі символів yj, zk щодо xi, дорівнює сумі інформації, що міститься в yj щодо xi і інформації, що міститься в zk щодо xi за умови, що значення yj відоме

. (3)

Кількість власної інформації у xI визначається з (2) при p(xI/ yJ) = 1

. (4)

Ця величина визначає кількість інформації, необхідне для однозначного визначення xi на виході каналу.

З урахуванням введеного поняття (4) можна перетворити вираз (2) до вигляду

,

Де I (xI / yJ) = - log p (xI / yJ) умовна власна інформація.

Середня кількість взаємної інформації виходить шляхом усереднювання (2) по всіх i і j :

.

Похожие статьи

-

Припустимо, що ми маємо дискретний канал, імовірність виникнення помилки в якому є близькою до нуля (у ідеалі = 0). Такий канал називають ідеальним...

-

Ентропія визначає міру невизначеності всієї безлічі повідомлень на вході каналу і обчислюється як середня кількість власної інформації у всіх...

-

Звичайно джерела передають повідомлення з деякою швидкістю, витрачаючи в середньому час Т на передачу одного повідомлення. Продуктивністю джерела...

-

Функції інформації - Кількісні інформаційні характеристики дискретних джерел повідомлень і каналів

Як уже підкреслювалося, інформацією називають відомості про навколишній світ, про процеси, що протікають в ньому. Інформація, зафіксована на носіях,...

-

Більшість пристроїв інформаційних систем відносяться до класу лінійних систем, які представляються у вигляді чотириполюсника з передатною функцією K(iщ)....

-

Імовірнісний характер інформації (де, коли, які повідомлення, скільки їх), імовірнісний характер перешкод потребують переходу від детермінованої моделі...

-

Оскільки інформатика має справу з процесами передачі і зберігання інформації, те важливе значення має кількісне вимірювання інформації. При цьому різні...

-

Джерела інформації мають фізичну природу, відрізняються по виду формованих повідомлень, енергетичній активності, імовірнісним характеристикам. Для...

-

У техніці інформацією вважається будь-яка послідовність символів, що зберігається, оброблювана або передана. Часто використовують простий і грубий спосіб...

-

Математичні моделі сигналів - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку

Відеосигнали u(t), розглянуті в 1, не є основними переносниками інформації. Вони переносять її по внутрішніх ланцюгах. Переносниками інформації на далекі...

-

Двійкові завадостійкі коди, Характеристики корегуючих кодів - Цілісність і доступність інформації

Характеристики корегуючих кодів Завадостійке (надмірне) кодування, що припускає розробку і використовування корегуючих (завадостійких) кодів, широко...

-

Математичні моделі завад - Математичний опис джерел інформації, сигналів, завад і каналів зв'язку

Природа завад різноманітна: шуми космічних об'єктів, атмосферні процеси, завади від сусідніх станцій, індустріальні завади й т. д. Сигнал, що надійшов на...

-

Загальна схема системи зв'язку - Теорія інформації як основа інформаційних технологій

Вона складається з 5 частин: 1. Джерело повідомлень, що створює повідомлення або послідовність повідомлень, які повинні бути передані. Повідомлення...

-

Цей канал, як і радіоканал, становить підвищену небезпеку. Електричний канал утвориться в технічних засобах і комунікаціях через паразитні зв'язки й...

-

Проблема забезпечення безпомилковості (цілісності, достовірності) передачі інформації в мережах має дуже важливе значення. Якщо при передачі звичної...

-

Принципи побудови завадостійких кодів - Цілісність і доступність інформації

Найчастіше як передумову при введенні кодів розглядають деякий початковий набір з m двійкових символів "0"и "1" (двійковий вектор), званий часто базовим...

-

Ефективна організація обміну інформації набуває все більше значення як умову успішної практичної діяльності людей. Об'єм інформації необхідний для...

-

Групові методи захисту від помилок - Цілісність і доступність інформації

З групових методів широке застосування одержали мажоритарний метод (принцип Вердана) і метод передачі інформаційними блоками з кількісними...

-

Підвищення вірогідності передачі При передачі даних по каналах зв'язку завжди виникають помилки. Причини їх можуть бути всілякі, але результат...

-

Способи модуляції - Захист інформації від витоку з телефонної мережі зв'язку

У модемах для телефонних каналів, як правило, використаються три види модуляції: частотна, відносна фазова (фазоразностна) і квадратурна амплітудна...

-

Цифрові скремблери - Захист інформації від витоку з телефонної мережі зв'язку

Під скремблюванням розуміється зміна характеристик речового сигналу таким чином, що отриманий модульований сигнал, маючи властивості нерозбірливості й...

-

Сьогодні практично всі сучасні телекомунікаційні технології передбачають використання цифрових методів обробки й передачі інформації, побудову...

-

Канали витоку інформації - Захист інформації від витоку з телефонної мережі зв'язку

Системи, створені спеціально для передачі інформації використаються людьми в повсякденній практиці у відповідності зі своїм призначенням і є офіційними...

-

Модель системи зв'язку - Цілісність і доступність інформації

В наслідок впливу завад та шумів результуючий сигнал SРез(t) на виході каналу зв'язку є сумою (для адитивних завад, які, як правило, домінують в каналах...

-

Кібернетичний підхід до поняття інформації - Теорія інформації як основа інформаційних технологій

Розглянемо підхід до поняття інформації з погляду кібернетики. Інформація відомості, які нас цікавлять. Інформація повідомлення, які володіють новизною...

-

Відношення поняття документ та інформація - Документ як засіб комунікації

Головною складовою документа виступає інформація, тобто найрізноманітніші дані, відомості, повідомлення, знання, призначені для передачі в процесі...

-

Як правило, на будинках в садоводствах, що знаходяться на відстані не більше 20 км. від ТЦ і активних ретрансляторів, використовуються однопрограммниє і...

-

Для определения необходимого числа каналов на участках между проектируемой станцией и заданными узлами связи дороги воспользуемся номограммой. Процент...

-

Випрямлячі перемінної напруги, Основні характеристики випрямлячів - Випрямлячі перемінної напруги

Випрямлячі використовуються в блоках харчування радіоелектронних пристроїв для перетворення перемінної напруги в постійне. Схема будь-якого випрямляча...

-

Приклади складних об'єктів - Теорія інформації як основа інформаційних технологій

Приклад. Подивимося на наше серце. Під час скорочування, воно викидає в судини кров під тиском. Кров ударяється об стінку артерії і виходять клацання,...

-

Аналогові й цифрові канали Під каналом зв'язку розуміють сукупність середовища поширення й технічних засобів передачі між двома канальними інтерфейсами...

-

Форми адекватності інформації - Теорія інформації як основа інформаційних технологій

Адекватність інформації може виражатися в трьох формах: семантичної, синтаксичної, прагматичної. Синтаксична адекватність. Вона відображає...

-

Визначення інформації. Інформація і дані - Теорія інформації як основа інформаційних технологій

Термін інформація походить від латинського informatio, що означає роз'яснення, інформування, виклад. У широкому значенні інформація це загальнонаукове...

-

Вступ - Захист інформації від витоку з телефонної мережі зв'язку

На сучасному етапі, коли відбулася корінна переоцінка цінностей, багато традиційних ресурсів людського прогресу втрачають своє першорядне значення. Але...

-

Маршрут перевезень - Цілеспрямовано вибраний шлях руху Транспортного засобу від початкового ВВ (пункту навантаження) до повернення до нього чи до...

-

В системе TANGARA RD применяется цифровой метод FDMA (частотное разделение каналов), совмещенный с TDD. Схема используемой модуляции - GFSK (частотная...

-

Стандарт IEEE 802.11g является логическим развитием стандарта 802.11b/b+ и предполагает передачу данных в том же частотном диапазоне, но с более высокими...

-

Опис функціональної схеми модему - Захист інформації від витоку з телефонної мережі зв'язку

На рис. 7.2 представлена функціональна схема мікросхеми СМХ869, а в таблиці 7.1 наведено опис вхідних і вихідних сигналів. Рисунок 7.2 Функціональна...

-

Протокол V.42 - Захист інформації від витоку з телефонної мережі зв'язку

Стандарт V.42, прийнятий ITU-T у листопаді 1988 року, визначає процедуру LAPM (Link Access Procedure for Modems), схожу по можливостях з MNP4. Переваги...

-

Види і характеристики радіо - і телевізійних антен

Види і характеристики радіо - і телевізійних антен Приймальні телевізійні антени перетворять енергію електромагнітних хвиль у ВЧ-енергію, що поступає по...

Кількісна міра інформації - Кількісні інформаційні характеристики дискретних джерел повідомлень і каналів