Мера информации по Шеннону - Измерение информации

Пусть до получения информации потребитель имеет некоторые предварительные (априорные) сведения о системе б. Мерой его неосведомленности о системе является функция H(б), которая в то же время служит и мерой неопределенности состояния системы.

После получения некоторого сообщения в получатель приобрел некоторую дополнительную информацию Iв(б), уменьшившую его априорную неосведомленность так, что апостериорная (после получения сообщения в) неопределенность состояния системы стала Hв (б).

Тогда количество информации Iв(б) о системе, полученной в сообщении в, определится как:

Iв(б) = H(б) - Hв (б),

Т. е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы.

Если конечная неопределенность Hв (б) обратится в нуль, то первоначальное неполное знание заменится полным знанием и количество информации Iв(б) = H(б). Иными словами, энтропия системы H(б) может рассматриваться как мера недостающей информации.

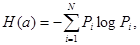

Энтропия системы H(б), имеющая N возможных состояний, согласно формуле Шеннона, равна:

Где Pi - вероятность того, что система находится в i-м состоянии.

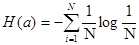

Для случая, когда все состояния системы равновероятны, т. е. их вероятности равны Pi =(1/N), ее энтропия определяется соотношением:

Часто информация кодируется числовыми кодами в той или иной системе счисления, особенно это актуально при представлении информации в компьютере. Естественно, что одно и то же количество разрядов в разных системах счисления может передать разное число состояний отображаемого объекта, что можно представить в виде соотношения

N=mN,

Где N - число всевозможных отображаемых состояний;

M - основание системы счисления (разнообразие символов, применяемых в алфавите);

N - число разрядов (символов) в сообщении.

Наиболее часто используются двоичные и десятичные логарифмы. Единицами измерения в этих случаях будут соответственно бит и дит.

Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объему данных, т. е.:

,

Причем 0<Y<1.

С увеличением Y уменьшаются объемы работы по преобразованию информации (данных) в системе. Поэтому стремятся к повышению информативности, для чего разрабатываются специальные методы оптимального кодирования информации.[2, 3-4с.]

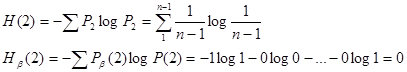

Пример. На абрисе тахеометрической съемки точки рельефа, между которыми возможна интерполяция горизонталей соединяются стрелками, которые указывают направление ската. До проведения эксперимента допустимо предположение соединения некоторой точки n с остальными n - 1 точками. При этом вероятность каждого соединения равна

Где число соединений.

Однако в результате эксперимента было установлено (получено экспериментально), что точка n соединилась лишь с одной точкой. Вероятность этого события а вероятность соединения с остальными точками равна нулю.

Тогда очевидно, что

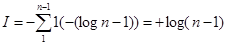

Следовательно, количество информации, доставляемой такой линией абриса равно

Похожие статьи

-

Введение, Измерение информации - Измерение информации

1. Каркасом послужил источник [1]. Он был дополнен теорией [2]. Примеры основной части №1 не подвергались изменениям. В ее заключении представлены схема...

-

ЛЕЧЕНИЕ И МЕРЫ ПРОФИЛАКТИКИ ГЕРПЕСА СОБАК, О вакцинации - Герперовирусная инфекция у животных

После того как собака заразилась вирусом герпеса, она никогда не сможет полностью от него избавиться. Большинство инфицированных собак при первоначальном...

-

Профилактика и меры борьбы - Лечение туберкулеза у животных

В целях недопущения заболевания животных туберкулезом не следует допускать перемещения их из других хозяйств, а также внутри колхоза или совхоза без...

-

Профилактика лейкоза, Меры борьбы с лейкозом - Лейкоз скота

Общие мероприятия по профилактике лейкоза крупного рогатого скота включают в себя соблюдение ветеринарно-санитарных требований при содержании, кормлении...

-

Профилактика и меры борьбы - Бешенство у животных

Санитарные правила СП 3.1. 096-96. Ветеринарные правила ВП 13.3. 1103-96. Руководители животноводческих хозяйств, предприятий, учреждений, организаций и...

-

Больным животным назначают голодную диету. Внутрь дают 1% р-р NaCl и отвар тысячелистника, как вяжущее средство. Для поддержания работы сердечно -...

-

Требования по профилактике туберкулеза животных и человека 1. Владельцы животных, руководители хозяйств, независимо от форм собственности, фермеры,...

-

Амбарный и рисовый долгоносики , жуки сем. долгоносиков, опасные вредители зерна и зернопродуктов. Распространены повсеместно (в сев. областях постоянно...

-

Лечение, Меры борьбы - Возбудители лептоспироза

При остром и подостром течении лептоспироза применяют сыворотку поливалентную гипериммунную против лептоспироза животных, стрептомицин, канамицин,...

-

Профилактика и меры борьбы - Диагностика и профилактика лептоспироза

В целях недопущения возникновения лептоспироза ввод животных для племенных и пользовательных целей разрешается только из благополучных хозяйств, при...

-

Инбридинг. Методы измерения. Вредные последствия и борьба с ними - Основы технологии животноводства

Инбридингом (родственным спариванием, инцухтом) принято считать такое спаривание, п ри котором отец и мать будущего потомства состоят между собой в...

-

Обработка почвы и меры борьбы с сорняками - Возделывание картофеля

Одним из основных условий, обеспечивающих получение высоких урожаев картофеля, является создание мощного, рыхлого, хорошо аэрируемого и достаточно...

-

Так как вирус, вызывающий кошачий инфекционный перитонит является мутацией широко распространенного вируса, профилактика заболевания сопряжена с...

-

1. Нагноение. Для профилактики и устранения нагноения используют Антисептики и антибиотики. Используют Сульфа амидные препараты, растворы Йода и др....

-

Болезни обмена веществ и меры их профилактики - Болезни обмена веществ и меры их профилактики

Остеодистрофия - это рассасывание костной ткани у взрослых животных. Чаще отмечается у коров при стойловом содержании зимой, весной, особенно в последний...

-

Индивидуальные средства защиты людей подбираются с учетом токсичности выбранных пестицидов и опасности выполняемых работ. Данные приведены в таблице 11....

-

Паракератоз - Болезни обмена веществ и меры их профилактики

Паракератоз - это заболевание, сопровождающееся поражением кожных покровов. Болеют все виды животных, но особенно свиньи. Причины болезни Недостаток в...

-

Ожирение - Болезни обмена веществ и меры их профилактики

Ожирение Является заболеванием, при котором в организме накапливается избыток жира, отлагающийся в подкожной клетчатке и других тканях, что приводит к...

-

Кетоз овец - Болезни обмена веществ и меры их профилактики

Кетоз овец представляет собой заболевание суягных овцематок за 3-4 недели до окота. Сопровождается нарушением обмена веществ, расстройством функций...

-

Кетоз молочных коров. - Болезни обмена веществ и меры их профилактики

Кетоз молочных коров является тяжелым заболеванием высокопродуктивных коров (чаще в возрасте 5-7 лет). Проявляется обычно в первые недели после отела и...

-

Предупредительные и истребительные меры борьбы - Защита сельскохозяйственных растений от болезней

Сельскохозяйственный истребительный вредитель агротехнический В основе борьбы с вредными организмами должны лежать своевременность и высокое качество...

-

Таблица 5 - Органолептическая оценка шерсти русской длинношерстной породы овец Показатели Однородная/Неоднородная Однородная Типы волокон Переходные...

-

Иммуностимулирующая терапия - Внутренние болезни животных

Сущность этой разновидности патогенетической терапии заключается в использовании препаратов, действие которых направлено на активизацию функций иммунной...

-

Общая информация Проект разработан с целью вовлечения выпускников профессионального образования и незанятого населения района в новые экономические...

-

Оптимизация управления и регулирования урожая сельскохозяйственных культур

Оптимизация управления и регулирования урожая сельскохозяйственных культур Продукционный сельскохозяйственный агроэкосистема биофильный Оптимизация...

-

Профилактика, Лечение, Меры борьбы - Африканская чума свиней

Основу профилактики представляют мероприятия, направленные на недопущение заноса вируса на территорию страны. С этой целью анализируются данные о...

-

Физическое состояние воды (температура и др.), химический состав, микробная обсемененность и т. д. оказывают заметное влияние на здоровье. Питьевая вода...

-

Сравнительная ветеринарно-санитарная экспертиза яиц уток разных пород

Введение Проблема питания является одной из глобальных социальных проблем в современном мире. Жизнь человека и других млекопитающих невозможна без...

-

Инкубируют икру в 8-литровых аппаратах Вейсса при температуре 1-2оС и в течение 240 суток. Рисунок 6 - Аппарат Вейса: а -- инкубационный сосуд; б --...

-

Какие культуры относят к масличным - Масличные культуры

В группу масличных входят растения, плоды или семена которых служат источником получения жирных масел. Иногда маслосодержащие плоды их употребляют и пищу...

-

Таблица 9 - Распределение по длине в основной пробе шерсти русской длинношерстной породы овец Классы длины волокон, см Р А Ра Ра2 11,6 - 12,0 10 -4 -40...

-

Течение и прогноз, Лечение, Профилактика и меры борьбы - Гиподерматоз у коровы

Протекает в скрытой форме и зависит от интенсивности инвазии поражения животного. В нашем случае интенсивность инвазий было незначительно. Прогноз:...

-

Теория органической матрицы - Теории возникновения уролитиаза у собак и кошек

Установлено, что в мочевых камнях всегда имеется белковый матрикс, служащий каркасом для осаждения солей [7]. Это явление привело к появлению еще одной...

-

Профилактика и меры борьбы, Заключение - Губкообразная энцефалопатия крупного рогатого скота

Меры, предотвращающие занос возбудителя из-за рубежа, в частности, с продуктами убоя от так называемых "бешеных" коров. Запрещен импорт из Великобритании...

-

Состав и функции органического вещества почв - Почвоведение как наука

Органическое вещество почвы представляет собой комплекс органических соединений, входящих в состав почвы. Эти вещества разделены на две группы: 1)...

-

Обзор и анализ существующих технологий - Механизация процесса доения с разработкой линии сепарации

Доильная установка -- одна из наиболее сложных машин в сельском хозяйстве. По многим технико-экономическим показателям (стоимости, металлоемкости,...

-

Заключение - Агроландшафтное земледелие

Значение севооборотов в повышении плодородия почвы и урожайности сельскохозяйственных культур доказано длительными отечественными и зарубежными полевыми...

-

При этом методе упрощается вся работа по подготовке и получению спермы, а самое главное, удается получать идеально чистую, стерильную сперму, обладающую...

-

Для предотвращения отравления сельскохозяйственных и диких животных, в том числе рыб, птиц, пчел, токсическими веществами, применяемыми для обработки...

-

Каждая собака, которая участвует в спорте или используется на службе, требует тренировки выносливости. А именно - улучшение состояния организма, при этом...

Мера информации по Шеннону - Измерение информации